Come fare SEO nel 2017 è un titolo abbastanza forte e lungi da me la presunzione di essere il depositario della verità assoluta. Sarebbe stato più corretto scrivere come Flavio farà SEO nel 2017, ma non mi piaceva molto come titolo. Quello che è certo è che tra la fine del 2015 e la fine del 2016 sono sorte tante novità in ambito SEO. Una SEO talmente differente da com’era molti anni fa e che ormai, se non fosse per alcuni punti cardine ancora validi, non si direbbe neanche una sua lontana parente (tecnicamente parlando). Il periodo che ci lasciamo alle spalle ci ha riservato parecchie sorprese e molti cambiamenti, soprattutto grazie a Google che ha “imposto” come al solito le sue regole.

E allora come fare SEO nel 2017? Di cosa dobbiamo tener conto? Basterà la sola SEO a dare visibilità ad aziende e blog sui motori di ricerca? La classifica di Google è ancora determinata soltanto dalla bontà del lavoro fatto su un sito web a livello SEO?

Indice dei contenuti

LA MIA SEO NEL 2017

Facciamo sparire subito ogni dubbio (semmai ce ne fossero) riguardo l’utilità della SEO per aumentare la visibilità e le conversioni dei siti web. La SEO risulta essere l’elemento cardine fondamentale al centro del quale ruotano tutti i progetti. Anzi… a mio parere lo specialista SEO dovrebbe essere il fulcro nelle attività online per ogni progetto, collaborando con Webmaster, Webdesigner, Social Media Specialist, Copywriters ed esperti di Web Marketing. E di seguito capirete anche il perché azzardo questa affermazione.

LE PAGINE DI GOOGLE

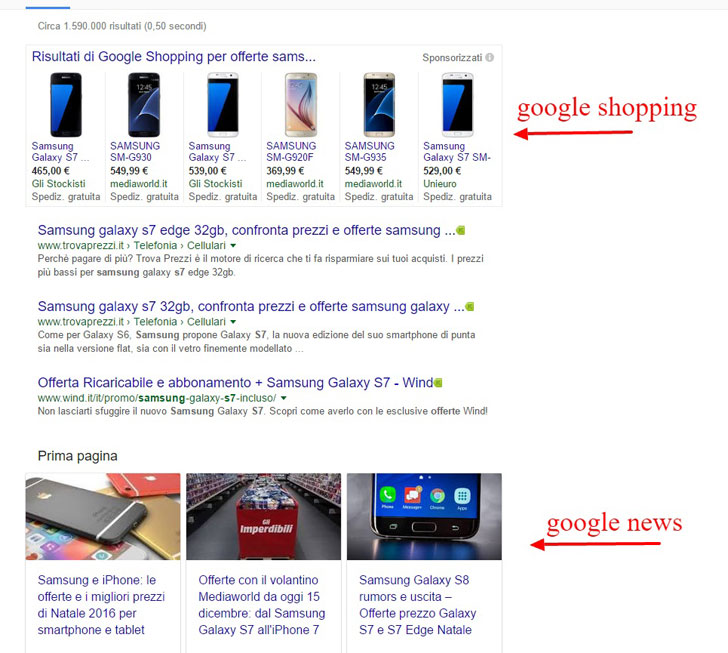

La classifica di Google (SERP) ormai non è fatta più di soli risultati organici e a pagamento. Gli elementi che popolano le pagine di Google aumentano sempre di più a scapito della visibilità dei classici snippets dei risultati organici. L’immagine successiva ne è un esempio.

La Serp di Google

All’inizio, come al solito, ci sono i risultati a pagamento, quelli generati dalle campagne pay per click (Adwords). Fino ad inizio 2016 erano tre annunci posizionati in cima, una decina di annunci sulla destra della pagina e un paio in fondo ai risultati organici.

Adesso invece Google ha deciso di eliminare i risultati a pagamento posizionati a destra e ha aumentato il numero dei risultati in cima alla pagina, portandoli da 3 a 4. Se si fa una ricerca da dispositivo mobile, questi coprono tutto lo schermo e per vedere il primo risultato organico bisogna scrollare non poco.

GLI ELEMENTI SULLA PAGINA VARIANO DA RICERCA A RICERCA

I risultati di ricerca variano soprattutto a seconda del tipo di query digitata (la frase inserita nel campo di ricerca di Google) e del luogo da dove essa viene effettuata. Se si cerca un prodotto da acquistare, ad esempio un vino, prima di tutto verranno mostrati i risultati di Google Shopping. Se si cerca una notizia vedremo in evidenza i risultati di Google News.

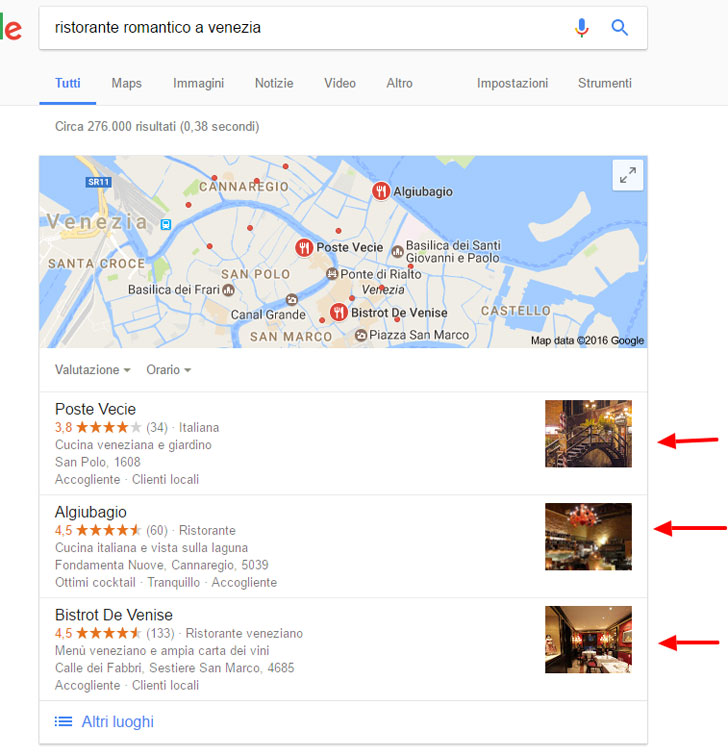

Se si va a cercare un hotel invece, subito dopo i risultati a pagamento, troveremo i risultati di Google My Business (ex Google Places), ovvero una mappa del territorio nel quale si trova la località di nostro interesse e di seguito i 3 hotel che per Google risultano più idonei a soddisfare la ricerca effettuata. Questo box può apparire anche alla destra della pagina se si cerca un hotel specifico.

LE MAGGIORI NOVITÀ SEO DI CUI DOVREMO TENER CONTO NEL 2017

AMP: AMP è un sistema studiato per migliorare la velocità dei tempi di caricamento delle pagine dei siti. I siti che hanno implementato AMP, a detta di Google, godranno a breve di una forte visibilità sulla pagina di ricerca, essendo presentati in formato di box con immagine, titolo e anteprima del testo.

Twitter: Notizia della fine del 2016 è che anche Twitter avrà il suo spazio in evidenza sulla SERP di Google. Non che Twitter non fosse presente già, ma pare che gli snippets dei tweet saranno più vistosi. Vedremo… Sarà forse l’ultima chance per questo social network di essere rivitalizzato?

RankBrain: Una novità interessantissima (datata fine 2015 ma perfezionata nel 2016) è l’implementazione all’interno degli algoritmi di Google del RankBrain. Cosa sia e che cosa faccia lo vedremo nel corso della lettura di questo articolo.

Google Phantom 4.0: Aggiornamento datato Luglio 2016. Con l’aggiornamento di questo algoritmo, Google rafforza la sua capacità di identificare quei siti che garantiscono una buona usabilità (User Experience) da parte degli utenti. Ne parleremo in seguito.

Google Possum: Si tratta di un update dell’algoritmo di Google riguardante la Local Search (Ricerca Locale). L’aggiornamento è datato 1 settembre 2016.

Penguin 4.0: Sempre nel Settembre scorso è stato rilasciato Penguin 4.0, l’algoritmo antispam di Google. A differenza dei rilasci precedenti, Penguin 4 lavora in tempo reale ed è granulare. Ci torniamo sopra tra un po’.

Mobile First Index: A Novembre Google ha annunciato che l’indice con il quale costruisce la sua classifica di ricerca, presto sarà Mobile First, ovvero che la SERP sarà restituita attingendo informazioni principalmente dalle versioni per dispositivi mobile dei siti web.

Passaggio da HTTP a HTTPS: Ecco un’altra novità da tenere in considerazione. Google inizierà a contrassegnare come non sicuri quei siti che non viaggiano su protocollo cifrato https. Dai primi risultati da me monitorati fino a fine Febbraio 2017, sembra che l’https abbia migliorato il posizionamento di quei siti che lo hanno implementato, dopo aver subito un piccolo periodo in cui per loro la serp era diventata un po’ ballerina.

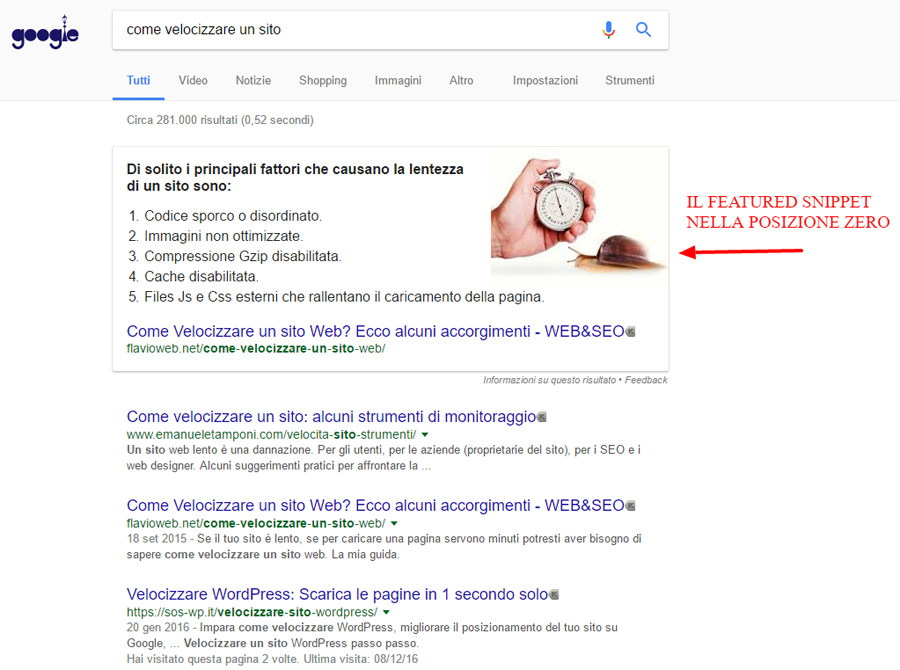

Featured Snippets: Infine è apparsa la cosiddetta “posizione zero“, ovvero uno snippet (featured snippets) in cima a tutta la lista che appare quando si digita una domanda che trova risposta in siti che hanno implementato i Knowledge Graph.

Il risultato che vedete in evidenza viene chiamato featured snippet e la posizione che occupa è stata chiamata posizione zero perché appare prima di ogni altro risultato

OK TANTE NOVITÀ. E ALLORA?

Il fatto che Google dia tanto spazio ai risultati pay per clik, e che riempia la pagina di rich snippets, schede local, pagine Amp e quant’altro, potrebbe far sembrare il tentativo di arrivare tra le prime posizioni della ricerca organica, con il classico snippet titolo-description-link, una perdita di tempo. Ma non è così perché…

- Per fortuna la maggior parte delle ricerche non restituiscono questo marasma di formati su Google.

- Chi vuole davvero acquistare un servizio, non si limita a cliccare sul primo sito che si presenta in SERP ma vuole approfondire e va ad esplorare anche i siti seguenti.

- Molti sono allergici ai risultati a pagamento. Li saltano a piè pari e iniziano ad esplorare dal primo risultato organico.

- Per far apparire uno snippet AMP sulla pagina bisognerà pure che la pagina sia ottimizzata in chiave testuale e SEO.

- Le prime posizioni della ricerca locale si conquistano con la qualità dei servizi offerti che generano recensioni positive e con una buona attività di “Local SEO“.

- La posizione Zero ed i Rich Snippet si possono ottenere solo grazie all’attività SEO

OSTACOLI O NUOVE OPPORTUNITÀ SEO?

Questi elementi di cui abbiamo parlato, più o meno recentissimi, possono diventare delle nuove opportunità per acquisire visibilità. Basta solo saperle sfruttare e per far questo bisogna saper utilizzare tutti i numerosi strumenti che Google ci da per tentare la scalata a queste nuove forme di visibilità. Questo, un buon professionista SEO lo saprà fare sicuramente ed è a lui che ci si deve rivolgere se si vuole stare al passo con i tempi ed emergere tra i numerosi competitors. Magari approfittando anche del fatto che parecchi di loro non andranno ad aggiornare la loro strategia SEO.

Il messaggio che vorrei far passare è che per un’attività, utilizzare questi strumenti può significare scavalcare nella classifica di Google quei competitors che fino ad oggi erano odiosamente posizionati meglio. Specie se quegli stessi competitors invece rimarranno fermi al vecchio modo di fare SEO.

Analizziamo quindi le cose di cui tenere conto per fare SEO al giorno d’oggi.

I CONTENUTI

Questa scommetto che la sapevate già. La produzione di contenuti freschi piace tanto a Google a patto che siano contenuti di qualità, ovvero che siano in grado di soddisfare le ricerche degli utenti. Faccio un esempio.

Mi è capitato di collaborare al rifacimento dei testi di un sito che fornisce numeri di telefono. Dall’analisi iniziale, questo sito aveva precedentemente subito una discesa nella classifica di Google a vantaggio di alcuni competitors, con la conseguenza che è sceso anche il numero di visitatori. Il perché a mio parere è semplice. Google è diventato sempre più bravo a riconoscere le pagine che rispondono meglio alle ricerche degli utenti. E mentre il sito per cui ho lavorato forniva un numero da chiamare per richiedere il contatto telefonico di una qualche azienda, i siti che lo avevano scavalcato quel contatto telefonico lo mostravano direttamente sulla pagina. Si tratta di un esempio semplice e lampante di come Google sia diventato bravo a distinguere le pagine che restituiscono nel miglior modo possibile le risposte alle query digitate, da quelle che lo fanno meno efficientemente. L’amico con cui ho collaborato mi perdonerà per questa mia analisi così schietta.

Questo caso va anche a rimuovere la convinzione (errata) che una pagina per essere ben posizionata deve contenere un testo lungo. Non è sempre così perché la necessità di un certo tipo di testo varia a seconda dei casi. Una guida ben scritta in ogni minimo dettaglio richiederà sicuramente un testo lungo. Fornire un numero di telefono invece no. Basteranno inserire un po’ di testo per dare rilevanza all’entità principale (il numero di telefono dell’azienda X), tipo le informazioni su cosa si può fare chiamando quel numero, quanto costa la chiamata ed il numero stesso. Il tutto ovviamente inserito in una pagina ottimizzata in chiave SEO. Sia la pagina della guida (con il testo lungo), sia quella del sito che fornisce numeri di telefono (con il testo corto) risulteranno essere per Google delle pagine di qualità.

Il lavoro di valutare la bontà dei contenuti lo fa un algoritmo chiamato Panda.

GOOGLE PANDA

Panda è un algoritmo che valuta la qualità delle pagine dei siti web ed è diventato uno dei principali segnali di ranking. Per far capire come questo algoritmo valuta i contenuti, Amit Singhal, sul blog per webmaster di Google, nel 2011 pubblicò delle domande molto esplicative che riporto di seguito.

- Vi fidereste delle informazioni presentate in questo articolo?

- Questo articolo scritto è da un esperto o appassionato che conosce bene l’argomento?

- Il sito ha contenuti duplicati, sovrapposizioni, o articoli ridondanti su argomenti simili con leggere varianti delle parole chiave?

- Ti fideresti di dare i dati della carta di credito a questo sito?

- Questo articolo ha errori di ortografia, stilistici o nei contenuti?

- Sono presenti temi basati su interessi reali dei lettori o solo contenuti aventi il solo obiettivo acquisire un buon posizionamento sui motori di ricerca?

- L’articolo fornisce contenuti originali ed interessanti?

- Ha la un valore sostanziale rispetto ad altre pagine sullo stesso argomento nei risultati di ricerca?

- Quanto controllo di qualità viene effettuato sui contenuti?

- L’articolo descrive accuratamente l’argomento in tutti i suoi aspetti?

- Il sito è un’autorità riconosciuta sul suo argomento?

- Per una query correlata alla salute, vi fidereste delle informazioni prese da questo sito?

- Riconosceresti questo sito come fonte autorevole quando lo menzionano per nome?

- Questo articolo fornisce una descrizione completa del tema?

- Questo articolo contiene un’analisi rilevante o informazioni interessanti che non siano già note ed ovvie?

- Creeresti un segnalibro con questa pagina da condividere o consigliare ad un amico?

- Questo articolo ha una quantità eccessiva di annunci che distraggono o interferiscono con il contenuto principale?

- Vedresti bene questo articolo pubblicato su una rivista stampata, un’enciclopedia o un libro?

- Gli articoli sono brevi, inconsistenti, o comunque privi di specifiche utili?

- Le pagine sono prodotte con cura ed attenzione verso i dettagli o tralasciano i dettagli?

- Gli utenti potrebbero lamentarsi quando leggono le pagine di questo sito?

Dalla risposta a queste domande, Google Panda decide quali siano le pagine di qualità, meritevoli di migliorare il proprio posizionamento e quali siano quelle di scarso valore che debbano essere retrocesse nella classifica dei risultati di ricerca. Dalle vostre risposte a queste domande potrete valutare voi stessi se avete inserito un contenuto di qualità nel vostro sito.

GOOGLE HUMMINGBIRD

Importante quanto Panda nel posizionamento delle pagine attraverso i contenuti, è a mio parere Hummingbird. Hummingbird ha il compito di “capire” il significato dei testi (più precisamente la semantica) , proponendo poi in SERP dei siti web che hanno i contenuti più adeguati per rispondere alla query dell’utente.

Creare dei contenuti Hummingbird-Friendly è una delle chiavi del successo per il posizionamento organico. Sfruttando le potenzialità di questo algoritmo si possono posizionare anche molte parole chiave correlate alla keyword focus (quella principale). L’efficacia di Hummingbird si rivela anche nelle attività di Link Building. Pubblicare su altri siti dei testi di qualità, permette di far salire il proprio sito sulla Serp, oltre che per la parola chiave scelta come anchor text del link, anche con diverse parole chiave correlate.

TEMPO DI PERMANENZA, FREQUENZA DI RIMBALZO E TASSO DI ABBANDONO

Per il posizionamento Google prende in considerazione altri parametri come il tempo di permanenza su un sito, la frequenza di rimbalzo ed il tasso di abbandono. Il segreto per incrementare il tempo di permanenza e diminuire il tasso di abbandono è a mio parere sempre legato alla qualità dei contenuti di una pagina. Qui non si parla solo di testo perché gli e-commerce ad esempio di testo ne hanno ben poco. Si tratta di stimolare l’interesse del visitatore inducendolo a soffermarsi a lungo sulle pagine del sito. Se una pagina è effettivamente utile o interessante per l’utente (attraverso il testo, immagini, video o proposte presenti), questi sarà invogliato a rimanervi per più tempo.

IL RANKBRAIN

Il RankBrain è una parte dell’algoritmo di Google. È il nome che Google ha dato ad un software di intelligenza artificiale per l’auto apprendimento che viene utilizzato per contribuire ad elaborare i risultati della ricerca. Il suo compito è capire il significato semantico delle ricerche ed apprendere i modi con cui si effettuano le ricerche. Cosa significa?

Il RankBrain apprende se una parola, nel contesto della frase digitata dall’utente sul box di ricerca, è utilizzata per voler dire una cosa o un’altra e, la cosa più importante, consente di capire le query e di affinare i risultati in modo da restituire solo quelli più attinenti.

Un esempio è quando si va a cercare un numero di telefono su internet.

Immaginiamo di voler cercare il numero di telefono di Amazon digitando la query “Amazon telefono”.

Prima, se si cercava il telefono di Amazon con la query “Amazon Telefono”, Google restituiva come risultati tutte quelle pagine ottimizzate per la chiave secca “Amazon Telefono” e spesso relegava nelle pagine successive testi (anche di maggior qualità) che contenevano la frase “numero di telefono di Amazon” perché ritenuta non completamente pertinente alla ricerca effettuata.

Tutti i webmaster quindi erano propensi a snaturare i testi infilandoci dentro questa parola chiave così com’è, pur sapendo che non era il modo corretto per scrivere “numero di telefono di Amazon”. Scrivevano per posizionarsi su Google e non per chi leggeva il loro articolo. L’utente che leggeva quel testo si trovava a dover fare un pochino di fatica per comprenderne il significato e spesso non trovava neanche la risposta che cercava.

Anche la Link Building era legata a questo modo di fare e proliferavano (e proliferano ancora) le anchor text dei link di questo tipo. Questa storia sembra sia finalmente finita.

Oggi possiamo scrivere sui nostri siti dei testi in forma corretta utilizzando la frase “numero di telefono di Amazon” e creare anchor text per i link esterni nella stessa maniera. Google capisce (ha appreso) che se uno digita sul box di ricerca “Amazon Telefono”, cerca il “numero di telefono di Amazon” e restituisce come risultato le migliori pagine ottimizzate per chi vuole conoscere il numero di telefono di Amazon.

In realtà Google ha annunciato l’introduzione del RankBrain nell’Ottobre 2015 ma gli effetti si sono sentiti per bene in questo 2016. In un “Question and Answer” tenuto a Marzo, Andrey Lippatsev, Search Quality Senior Strategist di Google, ha affermato che il RankBrain è uno dei 3 fattori di ranking più importanti per il posizionamento, insieme ai contenuti e ai link.

Approfondimenti sul Rank Brain (in inglese)

LINK INTERNI E LINK ESTERNI (LINK BUILDING)

I link ancora godono di una forte importanza nelle strategie di posizionamento, sia quelli all’interno del sito che quelli che provengono da altri siti. Il passaggio di link juice tra le varie pagine o da un sito all’altro, favorisce il posizionamento dei siti.

I link interni ci permettono di creare un collegamento da una pagina che tratta un certo argomento verso una pagina che magari ne approfondisce un aspetto. Questo potrebbe contribuire ad aumentare il tempo di permanenza sul sito. I link interni possono essere utilizzati per organizzare gerarchicamente le pagine e far capire a Google quali siano quelle più importanti del sito.

I link provenienti da fonti esterne invece, passano autorevolezza al sito, fattore che ne favorisce il posizionamento. A questo proposito sapete bene che non tutti i link sono uguali e che è meglio ricevere link da siti di qualità e a tema con gli argomenti trattati sulle nostre pagine.

Per valutare la bontà di un sito è possibile utilizzare strumenti come MOZ o Majestic SEO. Sono senz’altro delle indicazioni preziose ma fidatevi solo della vostra valutazione. Visitate il sito da cui potreste ricevere il link, guardate come è organizzato e se è aggiornato con una certa frequenza. Se vedete che è curato e non serve solo a ospitare testi per dare link a destra e a manca, potete pubblicarvi sopra tranquillamente. Anche se abbia un valore di Trust Flow vicino allo zero. Almeno io la penso così.

Approfondimenti sulla Link Building e su come farla senza rischio penalizzazioni

MARKUP DEI DATI STRUTTURATI

Altri elementi che entrano prepotentemente nell’elenco delle le cose da fare per ottimizzare un sito in chiave SEO sono i dati strutturati. Questi servono a far capire meglio a Google la struttura ed il contenuto della pagina.

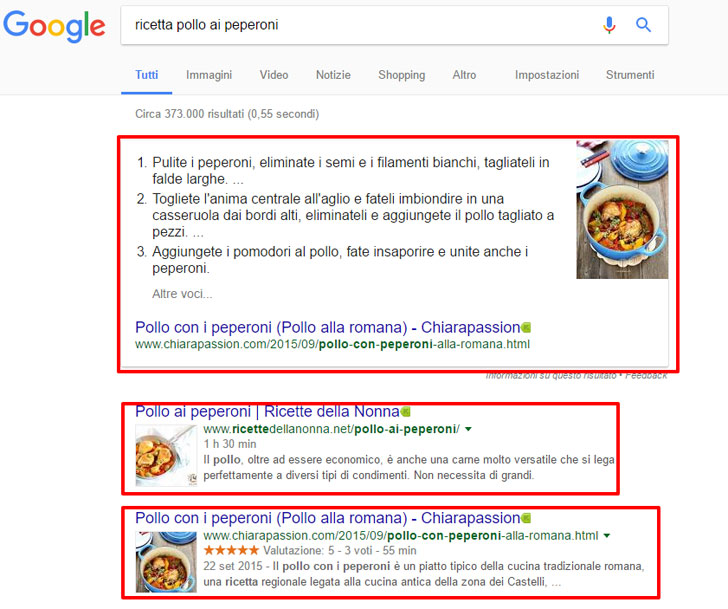

Google e gli altri motori di ricerca stanno utilizzando il markup dei dati strutturati in diversi modi, ad esempio, per creare rich snippet nei risultati di ricerca (quei risultati carini con le immagini, le stelline e tante altre cosine graziose che risaltano così prepotentemente rispetto a chi non ce l’ha).

Il vantaggio di implementare il markup dei dati strutturati è che consente a Google di usare queste informazioni per raccogliere dati aggiuntivi e altre funzioni da mostrare quando restituisce il risultato di una ricerca.

Implementare il markup dei dati strutturati è a mio avviso di fondamentale importanza. Si tratta di piccole porzioni di codice da inserire nelle pagine. Ecco un esempio che è possibile utilizzare per gli articoli:

<script type=”application/ld+json”>

{

“@context”: “http://schema.org”,

“@type”: “NewsArticle”,

“mainEntityOfPage”: {

“@type”: “WebPage”,

“@id”: “https://example.com/article”

},

“headline”: “Article headline”,

“image”: {

“@type”: “ImageObject”,

“url”: “https://example.com/thumbnail1.jpg”,

“height”: 800,

“width”: 800

},

“datePublished”: “2015-02-05T08:00:00+08:00”,

“dateModified”: “2015-02-05T09:20:00+08:00”,

“author”: {

“@type”: “Person”,

“name”: “John Doe”

},

“publisher”: {

“@type”: “Organization”,

“name”: “Google”,

“logo”: {

“@type”: “ImageObject”,

“url”: “https://example.com/logo.jpg”,

“width”: 600,

“height”: 60

}

},

“description”: “A most wonderful article”

}

</script>

Come potete vedere l’implementazione del markup permette di mettere sotto forma di dati:

- Il titolo dell’articolo

- Un’immagine

- L’autore

- L’azienda

- Il Brand Logo

- La descrizione breve di cosa parla l’articolo stesso.

Quando implementate i dati strutturati sul vostro sito state creando contenuti idonei per essere pubblicati da google in due categorie: Rich Snippet e Knowledge Graph Cards.

I RICH SNIPPET

I Rich Snippet sono risultati arricchiti di dati per pagine che ospitano alcune categorie di contenuti come ricette, articoli, video, luoghi, monumenti, ecc…

Rich Snippets Dati Strutturati

LE KNOWLEDGE GRAPH

Le Knowledge Graph Cards appaiono nella serp se siete autorevoli per determinati contenuti. Google può prendere i dati strutturati del tuo sito e importarli nel Knowledge Graph. Questi dati verranno utilizzati per dare risultati per risposte alle domande digitate o per dei box dove appaiono delle schede in cui vengono visualizzate informazioni per persone, organizzazioni, eventi, film, ecc…

Esempio Knoweledge Card con il mitico SEO Danilo Petrozzi

Per un utilizzo ottimale, i dati strutturati non devono essere relegati nel footer o nella sidebar ma essere presenti proprio nel corpo del testo.

Per testare se il markup dei dati strutturati è stato correttamente implementato si può utilizzare l’apposito tool messo a disposizione da Google. Questo strumento permette di verificare eventuali errori, indica dove si trova l’errore e suggerisce come risolvere.

Maggiori informazioni sul Markup dei dati Strutturati

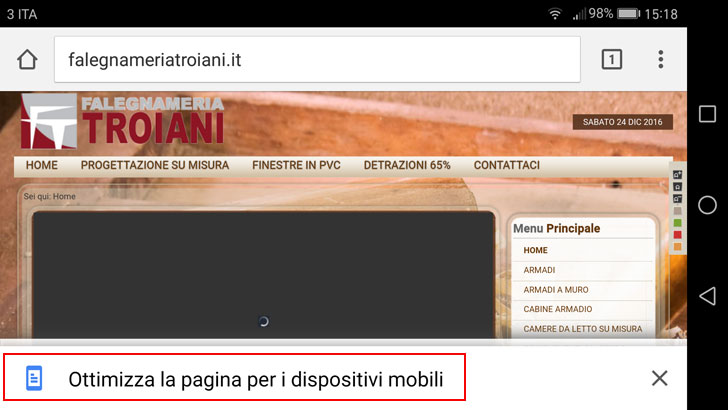

MOBILE FIRST INDEX

Altra novità 2016 che si farà sentire nel corso del 2017 è la decisione di Google di eleggere a suo indice primario quello che ricava le informazioni dalle versioni mobile dei siti web.

Questo vuol dire che le posizioni nella classifica di Google saranno determinate dai contenuti dei siti versione mobile.

Se si possiede un sito responsive, ovvero che presenta gli stessi contenuti sia per la versione desktop che mobile, il problema non sussiste. Se si ha versioni differenti tra sito desktop e mobile, con una migliore implementazione della versione desktop, bisognerà adeguare il sito mobile e portarlo ad avere gli stessi contenuti. Se si possiede solo un sito desktop è ora di rifarlo in versione responsive.

Ad oggi l’indice primario è ancora quello desktop ma l’indice mobile assumerà quel ruolo sicuramente nel corso del 2017.

SITI MOBILE FRIENDLY

La decisione di rendere l’indice mobile più importante di quello desktop si poteva intuire già da quando Google iniziò a spingere per la realizzazione di siti “mobile friendly“, ovvero siti che si potessero adattare e consultare agevolmente sui dispositivi mobili. Prima dicendo che la classifica di Google sui dispositivi mobili era diversa da quella restituita sui computer desktop e adesso facendo in modo che le SERP siano mostrate estrapolando i risultati direttamente dagli indici delle versioni mobile dei siti.

Per vedere se il tuo sito è Mobile Friendly, ovvero se è ottimizzato per i dispositivi mobili, puoi utilizzare questo tool messo a disposizione da Google.

Maggiori informazioni sul Mobile First Index

Qualche giorno fa, effettuando una ricerca da smartphone, mi è capitato di aprire un sito non ottimizzato per i cellulari per cui Google offriva la possibilità di aprirlo in modalità “mobile”. Non so se si tratti di uno dei tanti test di Google ma la cosa è stata molto utile perché mi ha permesso di navigare agevolmente il sito che mi interessava. Segue screenshot.

Tappando sopra “Ottimizza la pagina per i dispositivi mobili“, si visualizza una sorta di versione AMP. Spulciando il codice del sito, non si ha traccia di codice o plugin per AMP, né altro che possa far pensare ad un’implementazione di questo tipo.

TEMPI DI CARICAMENTO DELLE PAGINE DI UN SITO

Fare in modo che le pagine di un sito si carichino velocemente è diventata una necessità importante in ambito SEO. Importante sia per l’utente che per Google.

Un sito che si carica velocemente è visitato più volentieri dall’utente frettoloso che invece è incline ad abbandonare, prima ancora che si aprano, quei siti che hanno tempi di caricamento lunghi.

Un sito leggero, le cui pagine si caricano velocemente, è altrettanto ben visto da Google che dovrà impiegare meno risorse per scansionarlo. Se il bot di Google riesce a scansionare velocemente le pagine di un sito, sarà più incline a tornare a scansionarlo più frequentemente, specialmente se il sito in questione viene aggiornato spesso con nuovi contenuti e con l’aggiornamenti dei vecchi.

Questo si ripercuote sia sul posizionamento (grazie all’assegnazione di un maggior Crawl Budget), sia sulla velocità con cui vengono proposte in SERP le nuove pagine.

Per testare la velocità di caricamento delle pagine dei siti è possibile utilizzare l’apposito tool presente sulla Search Console di Google.

Approfondimenti Utili:

GOOGLE MY BUSINESS

Google My Business è l’account “brand” per attività commerciali, associazioni ed altre categorie business. Le schede che appaiono sulla SERP di Google, relative ad attività commerciali prendono i dati in gran parte dalle pagine My Business. Per creare una scheda commerciale su Google My Business occorre avere un account Google.

Qui entriamo nel campo della Local SEO o Local Search, dove uno dei massimi esponenti italiani è Luca Bove. Curare la Local SEO richiede tempo ed impegno ma garantisce risultati eccellenti per quelle aziende che hanno come target di riferimento i clienti residenti nella zona dove operano.

Non entrerò nello specifico perché il discorso è molto lungo. Quello che dovete sapere è che per fare una buona attività di Local SEO dovete curare la vostra scheda local arricchendola di elementi, immagini, riferimenti, favorendo le recensioni dei clienti, ottimizzando il sito collegandolo alla scheda Local e promuovendo l’attività su altri siti importanti popolandoli di dati riconducibili all’attività commerciale. Molto importante è che i dati dell’attività commerciale siano sempre uguali su tutte le pubblicazioni. Se sulla scheda local scrivete che siete in Via Tal dei Tali, 23/25, sul sito e sui siti esterni su cui pubblicate dovete riportare sempre l’indirizzo corretto (non ad esempio Via di tal dei Tali, 23).

Il risultato sarà la maggior visibilità sulla SERP di Google verso tutti i clienti che fanno ricerche locali. Ecco un esempio di SERP con schede local.

SERP con attività locali che hanno implementato la loro Local SEO

GOOGLE POSSUM

Google Possum è un update che si occupa di filtrare i contenuti della Local Search. Fino a Settembre 2016 la Local Search si basava su tre fattori principali:

- Pertinenza

- Distanza

- Rilevanza

Pertinenza tra la ricerca effettuata e le schede local da mostrare nei risultati. Distanza tra il punto in cui si effettua la ricerca e le schede local delle attività più vicine. Rilevanza, ovvero l’importanza o notorietà di un’attività locale rispetto alla ricerca effettuata (qui entrano in ballo la cura della scheda Google My Business, le recensioni e gli altri fattori che influenzano la Local Search).

A questi tre fattori ne è stato aggiunto un’altro: la diversificazione. Cosa si intende per diversificazione?

Prima di Google Possum, i fattori pertinenza, distanza e rilevanza la facevano in assoluto da padrone. Con Google Possum, un’attività che rispetti questi requisiti ed abbia una rilevanza maggiore rispetto ad altre, anche se si trova a maggiore distanza dal punto in cui viene effettuata la ricerca, viene mostrata tra i risultati in evidenza della classifica locale.

Con Google Possum, se una persona cerca una certa attività in una città, gli possono essere mostrate, se meritevoli, anche quelle attività con sede fisica al di fuori della città stessa. Precedentemente, questi esercizi commerciali erano invece sfavoriti.

Altro aspetto da evidenziare rispetto alla diversificazione è quello relativo agli indirizzi dove sono presenti più attività dello stesso tipo. Se ad uno stesso indirizzo, nello stesso palazzo, vi sono 5 notai, non verranno più mostrate tutte e 5 le schede, anche se quell’indirizzo è il più vicino al luogo dove viene effettuata la ricerca di un notaio. Questo non vuol dire che uno viene mostrato e gli altri 4 scompaiono perché cliccando sul link “altri luoghi” e scorrendo l’elenco, troveremo anche le altre 4 schede.

ORGANIZZAZIONE DELLE PAGINE E GERARCHIA

Anche una buona organizzazione delle pagine del sito è un fattore che aiuta il posizionamento su Google. Innanzi tutto esse devono fornire le risposte alle ricerche degli utenti in maniera chiara ed immediata.

Sei un’azienda? C’è il tuo numero di telefono bello in evidenza sulla parte superiore della pagina? Ci sono le informazioni per raggiungerti? C’è un form di contatto?

Il sito poi dovrebbe essere facile ed intuitivo da navigare, senza tanti effetti speciali che vanno a discapito dell’usabilità, specie sui dispositivi mobili.

Infine si dovrebbe curare l’ordinamento gerarchico delle pagine ed ottimizzare il Crawl Budget e questo lo si può fare attraverso l’utilizzo del rel=”nofollow” ad alcuni link interni che portano a pagine meno importanti (per esempio quella della policy) o con altri metodi alternativi.

Approfondimento: Come aggiungere il rel nofollow nel menu di Wordpress.

AMP

Preciso subito che ad oggi AMP non è un fattore di posizionamento nell’algoritmo di Google. Però Google ha annunciato che presto appariranno in SERP dei box in bella evidenza riservati alle pagine AMP pertinenti con la ricerca dell’utente.

Amp è un formato ideato per velocizzare i tempi di caricamento dei siti ed è facilmente implementabile.

I siti che dovrebbero implementare Amp, sono soprattutto quelli che pubblicano notizie.

Ecco una guida su cos’è AMP e come implementarlo su WordPress. Se invece volete testare le pagine AMP del vostro sito potete utilizzare lo strumento messo a disposizione da Google.

PHANTOM 4.0

Google Phantom è l’algoritmo incaricato principalmente di valutare il livello di usabilità dei siti e fu creato per automatizzare (in parte) il lavoro dei Quality Rater. I Quality Rater sono delle persone umane che esaminano e verificano manualmente la qualità dei siti web. Non tutti i siti finiscono sotto le grinfie di queste figure, ma solo quelli che gli algoritmi non riescono a valutare con precisione. Nei compiti dei Quality Rater non rientra solo la verifica della user experience, ma anche la qualità dei contenuti e la valutazione dei risultati della serp. In pratica valutano se i siti proposti nella serp per una certa query, rispondono (qualitativamente parlando) alle linee guida di Google. I Quality Rater possono decretare lo slittamento all’indietro di tutte quelle pagine che a loro giudizio non meritino di occupare posizioni più rilevanti.

Nel lavoro di valutazione, i Quality Rater seguono le linee guida del Search Quality Rating Guidelines. La lettura del manuale riservato ai QR, mi ha aiutato a migliorare parecchi aspetti dei siti che seguo. Ecco la copia da scaricare, aggiornata al 2016. [Download Manuale Linee Guida Quality Rater di Google, PDF 8,21 Mb, Eng]

Google Phantom valuta la qualità delle singole pagine. Per cui un’eventuale penalizzazione (o per meglio dire, la perdita di posizioni) dovuta a Phantom, colpirebbe solo le pagine con una bassa user experience e non l’intero sito.

PENGUIN 4.0

Si chiama Penguin ed è l’algoritmo più temuto dai SEO di tutto il mondo. Quello che penalizza i siti a causa di un profilo di link in entrata discutibile e di basso profilo. Fino ad agosto scorso, Penguin veniva rilasciato ogni tot di tempo. Lui scansionava la rete a caccia di siti che ricevevano troppi link spammosi e poi gli dava una bella randellata facendoli precipitare nella SERP. Un sito penalizzato da Penguin vedeva le proprie visite azzerate da un giorno all’altro. Per uscire dalla penalizzazione si doveva attendere il rilascio di un nuovo rollout e incrociare le dita.

Penguin 4.0 presenta due differenze sostanziali con le precedenti versioni:

- scansiona permanentemente i siti web, ovvero lavora in “real time” in quanto è parte integrante del core di Google

- è granulare, quindi colpisce la singola pagina anziché tutto il sito

Il primo aspetto fa in modo che se un sito viene penalizzato, il webmaster se ne può accorgere subito e correre ai ripari. Essendo un algoritmo in real time, una volta sistemata la situazione, si può fare subito richiesta di riconsiderazione a Google ed uscire dalla penalizzazione in pochi giorni.

Il secondo aspetto fa in modo che se una pagina viene colpita da una penalizzazione da Penguin, sarà solo quella pagina che perde posizioni, mentre il resto del sito non viene interessato.

Un’interessantissimo articolo di approfondimento su Penguin 4 lo potete leggere sul Blog di tagliaerbe.com.

L’HTTPS

Il protocollo https, consente ai dati di viaggiare in maniera cifrata. Google ha in pratica imposto l’https ai siti web che contengono form di contatto, booking con transazioni in denaro, login form, ed altri form dove devono essere inseriti dati sensibili.

Dai miei dati risulta che i siti passati da http ad https, abbiano beneficiato di un miglioramento nel posizionamento. Per completezza, ho scritto una guida su come passare un sito web da http ad https.

GLI ELEMENTI CLASSICI

Concludo questa carrellata di elementi da tenere in considerazione se si vuole fare SEO nel 2017 con il ricordare l’importanza di avere titoli, url, tag title, tag h1 e tag h2 ottimizzati e contenenti le keyword con cui ci si vuole posizionare.

Google ha anche aumentato il numero di caratteri del titolo visualizzati nello snippet della pagina di ricerca. Per la precisione ha aumentato i pixel a disposizione. Quindi ok a titoli più lunghi, specialmente per le versioni mobile, il cui titolo può superare tranquillamente i 70 caratteri.

Ricordo che anche i vari tag possono e devono essere ottimizzati con l’utilizzo dei microdati. Ecco un esempio:

<div itemscope itemtype=”http://data-vocabulary.org/Organization”>

<h1 itemprop=”name”>Pizza Pazza</h1>

<p itemprop=”address” itemscope itemtype=”http://data-vocabulary.org/Address”>

<span itemprop=”street-address”>Via della Pizza, 30</span>,

<span itemprop=”locality”>Pizzopoli</span>,

<span itemprop=”region”>Roma </span>.

</div>

Qui alcuni esempi di codice per l’implementazione dei microdati sui siti web.

E non vi affannate a scrivere testi pieni zeppi di parole chiave…. Google vi capisce e vi posiziona esattamente dove meritate di essere, anche scrivendo in maniera normale. Concentratevi sulla qualità dei contenuti… fidatevi.

E se ho dimenticato qualcosa in questa mia personalissima guida su come fare Seo per il 2017, non esitate a farmelo notare nei commenti.

LETTURE CONSIGLIATE

[amazon_link asins=’B00RY8CY9Q,8868953447′ template=’ProductAd’ store=’flaviowebnet-21′ marketplace=’IT’ link_id=’b994714d-ec79-11e6-840c-9162e96e19e0′]

Il funzionamento di google spiegato con parole comprensibili anche per una neofita come me. Complimenti Flavio e grazie per questo interessantissimo articolo.

Grazie Angela. Troppo buona

Ciao Flavio.

Ottimo articolo, ma io avrei una domanda.

Ho letto che usare siti satelliti verso un Money site è una pratica che Google non condivide.

Ma se io comprassi domini per specifiche parole chiave, offrendo contenuti di alta qualità, che aiutino il lettore a risolvere un problema, perchè dovrei essere bannato?

La mia idea è di acquistare domini per le parole chiave principali, anche perchè sono sicuro che il nome del dominio, sia ancora uno degli aspetti principali, per comparire in prima pagina e dirottare i navigatori sul mio sito principale, offrendo al tempo stesso una soluzione al problema specifico.

La pbn è vietata da Google, ma io non vorrei acquisire domini scaduti o cose simili. Vorrei piuttosto comprare domini con parole chiave esatte come ad esempio ” essereprimisugoogle.info”, scrivere un articolo di qualità e dirottare gli utenti verso il mio Moneysite.

Non vedo la differenza tra questa pratica e scrivere post su un blog di qualcun altro per mettere un anchor text al mio sito.

O peggio ancora comprare back link su fiverr o cose simili.

Spero che avrai il tempo per rispondermi e grazie anticipatamente

Ciao Massimo.

Grazie per il tuo intervento e scusa il ritardo nella risposta ma c’è stato il fine settimana di mezzo.

Il tuo ragionamento non fa una piega ma….

Comprare domini con specifiche parole chiave, (EMD, ovvero exact match domain) sembra funzioni ancora, checché ne dicano molti. Popolarli con articoli di qualità va benissimo.

Però:

1. Popolare di contenuti il tuo money site, immagino ti prenda già del tempo

2. Popolare anche solo altri 5-6 domini per linkarlo ti prenderà ancora più tempo e sono molti i casi di abbandono proprio per mancanza di tempo e anche di idee.

3. I domini che acquisti dovrebbero stare su classi di IP diversi.

4. Prima di vedere l’effetto sperato i nuovi domini dovrebbero acquisire trust e ci vuole tempo

5. Quanti link vuoi ottenere dallo stesso sito? Cosa faresti, apriresti un dominio e linkeresti 10-15 articoli verso il money site? Sarebbe naturale per Google vedere una serie di siti nuovi che rilasciano 10-15 link verso lo stesso sito?

6. Tu ce l’hai tutto questo tempo per lavorarci e per attendere i risultati? Quanti siti puoi aprire e dedicarti alla produzione di contenuti di qualità su ognuno di loro? Hai qualcuno che ti aiuta a farlo?

7. Sin dove potresti arrivare avvalendoti della manciata di siti per i quali avresti del tempo da dedicargli? Quando arrivi al massimo dei risultati e poi non ottieni più l’effetto sperato cosa fai? Ne apri altri? Nel frattempo magari capita che ne abbandoni qualcuno e il valore dei link presenti su questi cala con il tempo.

Sarebbe una corsa senza fine che non porta da nessuna parte, tranne che a trascurare il money site per mancanza di tempo.

Ottenere link da altri siti invece consente di beneficiare immediatamente del trust già acquisito da questi domini. Puoi dedicare più tempo alla produzione di contenuti utili sul tuo sito (che è la pratica migliore). Nel tempo puoi acquisire centinaia di link, invece di quella manciata che otterresti dai siti che saresti in grado di ottenere con il metodo che proponi. Infine, curando i contenuti del money site alla fine qualche link naturale lo ottieni sicuramente. Fidati.

Il mio piccolo blog ad esempio non ha molti link in entrata ma attraverso il content curation ha acquisito molto trust, al punto che qualsiasi cosa scriva si posiziona abbastanza bene. I pochi link che ho sono dai commenti che ho postato su altri siti (cosa che ho fatto per partecipare a delle discussioni interessanti e non per il linketto nofollow che rilasciano) e qualche link naturale guadagnato con i contenuti. Per arrivare a questo ci è voluto tempo. Se mi servissi di link da siti con medio-alto trust avrei molti visitatori in più e maggior visibilità. Ma questo l’ho potuto fare perché è il mio sito. Se fosse stato il sito di un cliente a cui portare risultati in un arco di tempo stabilito l’unica strada percorribile, fintanto che la produzione di contenuti inizi a dare risultati, è l’acquisizione di link da siti esterni.

Un ottimo articolo. Di recente ho letto anche Link Building di Ivano di Biase. Consiglio per ampliare anche i fattori off-page oltre ai 2 libri citati.

Ciao Egidio. Grazie.

Si le risorse messe a disposizione da Ivano con il suo libro sono eccezionali, al punto che ho deciso di fare una recensione al libro (di solito non ne faccio). Purtroppo quando scrissi questo articolo ancora non era uscito.

Un abbraccio.